Annonse

Etter prøver til elsker Bing Hvordan Bing spådommer har blitt så braPå tide å slutte med dagjobben og begynne å spille via Bing Predictions? Ikke helt, men la oss se på hvordan Bing har blitt så flink til å forutsi fremtiden. Les mer , flørt med det forbedrede personvernet til duckduckgo 10 nyttige DuckDuckGo øyeblikkelig svar som sparer deg for tid og noen få klikkInstant Answers er en samling av DuckDuckGo godbiter som potensielt kan gjøre ditt søk på nettet noe enklere. Her er ti fra en enorm liste du kan prøve ut på denne alternative søkemotoren. Les mer , og (skodde) til og med å prøve å se om Yahoo var noe bedre enn forrige gang jeg brukte det (circa 2004), kan jeg fremdeles ikke finne et bedre alternativ for online søk enn den regjerende mester, Google.

Gapet blir mindre, men til syvende og sist er Google fremdeles konge på grunn av resultatene, hastighet som nettsteder indekseres og søk blir utført, og deres konstante trykk for å bli jevn bedre.

Etter et halvt dusin (eller flere) mislykkede forsøk gjennom årene å finne

et bedre alternativ 13 alternative søkemotorer som finner det Google ikke kanGoogle Søk kan fortsatt ikke gjøre alt. Disse 13 alternative søkemotorene kan ta seg av noen nisjejobber for deg. Les mer , førte det til at jeg prøvde å tyde hva som gjør Google bedre enn konkurrenter på dette området.Dette er hva jeg fant.

En kort historie om søkemotorteknikk

For det første føler jeg at det sannsynligvis er lurt å se på noe av teknologien som driver søkemotorer Hvordan fungerer søkemotorer?For mange mennesker er Google Internett. Det er uten tvil den viktigste oppfinnelsen siden selve Internett. Og mens søkemotorer har endret seg mye siden, er de underliggende prinsippene fortsatt de samme. Les mer , og selskapene som fikk oss hit.

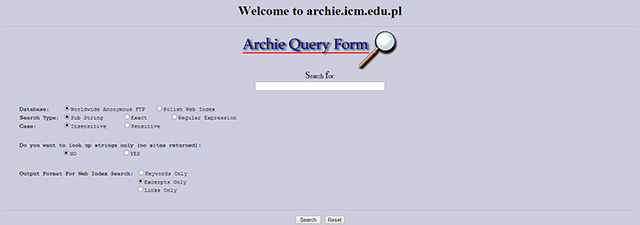

The Creation of Archie (1990)

Archie er mye antatt å være den første søkemotoren. Til tross for tilsynelatende primitiv nå, var Archie et verktøy som indekserte offentlig tilgjengelige FTP-nettsteder i et forsøk på å la brukere finne spesifikke filer. Dette var verdensomspennende internett, så du må ha tilgang til Archie-serverne ved hjelp av en lokal klient eller gjennom Telnet Hva er Telnet og hva er dets bruk? [MakeUseOf Explains]Telnet er et av de teknologiske begrepene du noen ganger kan høre, men ikke i en annonse eller en liste over vaskerier over noe produkt du kan kjøpe. Det er fordi det er en protokoll, eller et språk ... Les mer , som er en nettverksprotokoll som gir mulighet for tilkobling av to datamaskiner på samme nettverk.

Archie ansporet til innovasjon i tilleggsteknologier som opererte på lignende måte, for eksempel Veronica og Jughead, VLib, Gopher og andre. Disse teknologiene var pionerene i søkeindustrien, selv om de raskt ble erstattet av mer avanserte teknologier.

World Wide Web Wanderer (1993)

World Wide Web Wanderer ble opprettet i 1993 og var den første bot opprettet for å indeksere nettsteder og automatisk sette dem inn i en database. Wandex startet, som det ble, en måte å måle størrelsen på nettet ved å telle aktive servere over hele verden for å måle vekst. I stedet ble det blåkopien for moderne web-edderkopper, som er ansvarlige for å gjennomsøke nettet for å indeksere innholdet.

Excite (1993)

Excite var et prosjekt av seks studenter ved Stanford University som forsøkte å bruke statistisk analyse av sammenhenger på felles språk for å forbedre relevansen i indeksering. Excite - da kjent som Architext - brukte journalister for å skrive korte nettstedomtaler for forbedret brukervennlighet sammenlignet med mer primitive linkbaserte søkemotorer og kataloger.

The Search Engine Boom (1994)

1994 var sannsynligvis det største året i søkemotorenes historie. I løpet av et 12-månedersspenn så vi lanseringen av Infoseek, AltaVista, WebCrawler, Yahoo! og Lykos.

- Infoseek: Tillat brukere å sende inn nettsidene sine i sanntid og indekserte dem automatisk basert på brukerdefinerte kategorier.

- Altavista: Den første søkemotoren som bruker ubegrenset båndbredde, tillater søk etter naturlige språk og bruk av søkemodifiseringer for å godkjenne resultater.

- WebCrawler: Den første søkeroboten som indekserte hele sider i motsetning til bare titler eller titler og beskrivelser.

- Lycos: Den første søkemotoren som sorterte etter relevans. Lycos hadde også den største databasen med lagrede nettsteder, og på sitt høydepunkt (ca. 1996) hadde tjenesten gjennomgått og indeksert over 60 millioner nettsteder.

Søkemotorer i løpet av denne tidsperioden (og flere år senere) benyttet seg av metakoder som inneholdt tittel, beskrivelse og søkeordelementer lagt til et nettsted av webansvarlig. Disse kodene, samt nøkkelordetetthet i teksten til et nettsted, var de primære rangeringsfaktorene som hjalp edderkopper med å identifisere og indeksere innhold på riktig måte.

Det åpnet også døren for nettsøppel da tidlige SEO-eksperter raskt lærte seg å manipulere dette systemet ved å fylle nøkkelord i koder og innhold på en unaturlig måte i et forsøk på å spille systemet.

Ask / Ask Jeeves (1997)

Ask - og deres Ask Jeeves-tjeneste - brukte menneskelige redaktører for å prøve å liste opp populære brukersøk-spørsmål til lister over både partner- og betalte inkluderingsnettsteder. Tjenesten brukte automatisering i form av et rangeringssystem kalt DirectHit, som forsøkte å rangere nettsteder etter popularitet, men de fant ut at dette var for enkelt å manipulere og slutte å bruke motoren noen år seinere.

MSN / Bing (1998/2009)

MSN lanserte sin egen søkemotor for å piggyback på suksessen til andre Microsoft-produkter og overføre til online søk. Søkemotoren stolte på Overture, Looksmart og andre kataloger med betalt inkludering for å gi søkeresultater til Google beviste suksessen med backlink-modellen.

Dette konseptbeviset fra Google førte til at MSN tok i bruk en lignende strategi - selv om den ikke var like god - i 2004.

I 2009 omdirigerte MSN som Bing, og forbedret brukergrensesnittet, for å inkludere inline search (forslag som vises mens du skriver), innhold som vises på søkeresultatsiden (i motsetning til å måtte klikke på en kobling til ett av søkeresultatene), og en rekke nye funksjoner designet for å gjøre søk enklere og mer tilgjengelig.

Hvordan Google ble best (og hvorfor det fortsatt er)

På slutten av 90-tallet hadde søkemotorer blitt nesten ubrukelige på grunn av relevansen (eller mangelen på) søkeresultater og utbredelsen av nettsøppel. Før lanseringen i 1998, og i et halvt tiår etter, hadde konkurrentene virkelig ikke noe svar på monteringsproblemene forårsaket av nettsøppel og manipulering av søkemotorer - som til slutt ble kjent som SEO (søkemotor optimalisering).

Gå inn på Google.

Google startet som et prosjekt - kjent som BackRub - av Larry Page og Sergey Brin i 1996. Målet med dette prosjektet var å revolusjonere søk ved å bruke lenker som den primære rangeringsmetrikken for å forbedre relevansen. Teorien - kjent som sitasjonsnotasjon - dreide seg om ideen om at hvert nettsted som lenket til et annet nettsted i det vesentligste uttrykte sin tillit til innholdet som ble tilbudt på sidene. Disse koblingene fungerte som stemmer, og ankerteksten i koblingen fungerte som en måte å indeksere nettsteder basert på hva andre ga ut disse stemmene for.

Teknologien var spennende, og det førte til at Brin og Page forsøkte å selge den til konkurrenter i søkeverdenen for en rapportert $ 750.000. Heldigvis var det ingen som var interessert. Tilbake til tegnebrettet fortsatte Page og Brin å forbedre teknologien, og i 2000 var Google den største søkemotoren i verden.

Slik holder Google seg på toppen

Tilpasningsevne er kanskje den beste måten å beskrive hvordan Google forblir den mest brukte søkemotoren i verden. Når markedsførere og søkemotor-spesialister lærer å manipulere systemet, endrer Google det. Når nye teknologier - for eksempel sosiale medier - begynner å spille en aktiv rolle i samtalene våre, finner Google en måte å integrere dem i algoritmen for å forbedre relevansen. Når søkevanene endres, endrer Google seg med dem.

Google ser stadig på, analyserer og utvikler seg. Ved å bruke de enorme datamengdene de samler inn fra hver enkelt av oss ved å bruke produktene sine, er de det i stand til hele tiden å levere et bedre, mer relevant og brukervennlig produkt enn noen av deres konkurrenter.

Hvordan fremtiden for søk ser ut

Selv om Google er på topp og det ikke ser ut til å være noen konkurrenter i horisonten som kan slå dem løs, endrer ting seg raskt på nettet. Dette er hva Google - og andre - gjør for å forbedre relevansen av søkeresultatene våre både nå og i nær fremtid.

Forstå brukernes intensjon og semantikk

Søkemotorer - inkludert Google - brukes til å levere resultater basert på hvor godt spørsmål samsvarte med websider. Nå, Bing, Google og Yahoo! prøver alle å forbedre resultatene sine basert på å forstå intensjonen bak dem, kjent som semantisk søk Hva semantisk markup er og hvordan det vil endre Internett for alltid [Teknologi forklart] Les mer .

For eksempel, hvis en bruker søker etter "Best Seafood" - ville resultatene i de siste årene stole på hvilket nettsted som ble ansett for å være mest autoritativt for disse søkeordene. Nå legger søkemotorer større vekt på å forstå hva du leter etter spesifikt, slik at de kan levere de mest optimerte resultatene. I dette tilfellet leter brukeren mest sannsynlig etter de beste sjømatrestaurantene i nærheten, eller oppskrifter. Å forstå at på tvers av billioner mulige søk er det ting blir komplisert.

Større vekt på beliggenhet

Eksemplet ovenfor for et spørsmål om sjømat er en av de viktigste grunnene til at stedet blir så viktig. Du leter sannsynligvis ikke etter sjømatrestauranter i San Francisco hvis du bor i Singapore (men hvis du er det, bare legg til "i San Francisco" i spørringen). Stedsbasert søk endrer alt ettersom alle de store søkemotorene nå bruker posisjonen din for å levere tilpassede resultater for søkene dine.

Forbedret mobilopplevelse

2015 var første gang i historien at mobiltrafikken overskred den for bærbare datamaskiner og stasjonære maskiner, og det er fortsatt en trend med rask bevegelse oppover. Faktisk er den fleste nettrafikk som stammer fra smarttelefoner, søkerelatert. På grunn av den endrede tiden vi lever i, er det viktig å levere en polert mobilopplevelse til mobilbrukere.

Google gjør nettopp dette ved å gi ut en ny mobilalgoritme som skjuler nettsteder som ikke vises ordentlig på mobile enheter. Denne algoritmiske endringen er bare for mobiltrafikk, men den skal berike opplevelsen for mobilbrukere og lede an for videre mobilinnovasjon.

Yahoo! er en annen stor søkemotor med fokus på mobil. Administrerende direktør Marissa Mayer (en tidligere Google-ansatt) har skiftet fokus for Yahoo! for å prioritere mobil som et primært middel for å gjenvinne relevansen.

Kunnskapsgrafikk

Bing og Google er begge i stor grad investert i å bruke de massive databasene med informasjon for å gi raske informasjonsbiter for spesifikke nøkkelord og uttrykk. For å forbedre brukeropplevelsen prøver begge å eliminere ytterligere trinn som brukeren må ta for å finne informasjon, og i stedet stole på kunnskap graf teknologi Et dyptgående blikk på Googles nye kunnskapsgrafikk Les mer .

For eksempel inneholder filmer, kjendisnavn eller stedsrelaterte spørsmål nå informasjon om spørringen øverst på siden. For raske søk kan dette spare deg for ytterligere trinn for å måtte grave dypere gjennom resultatene eller besøke flere nettsteder for å finne informasjonen.

Dette har store implikasjoner på mobil, så vel som stemmesøk (for eksempel Siri eller Google Nå), ettersom de fleste søk er raske forsøk på å hente ut informasjon i motsetning til uttømmende søk etter forskning.

Finne nye måter å forbedre algoritmer på

Søkemotorer er i krig med hverandre, så vel som de ukjente som lurer rett rundt hjørnet. I et forsøk på å være best, må hver og en levere svært relevante resultater og raskt. Som sådan endres algoritmer på alle større søkemotorer kontinuerlig i et forsøk på å ligge foran kurven, og finne nye beregninger som kan føre til bedre resultater.

Et av de mest spennende eksemplene på dette kan være Kunnskapsbasert tillitspoeng Kan Google bruke en algoritme for å bestemme sannhet?Google forsker på om algoritmen kan inkludere sannhet som en rangeringsfaktor. Hva betyr det for nettet? Les mer , basert på et patent inneholdt av Google. Selv om Google direkte har nektet enhver intensjon om å bruke dette patentet i søkealgoritmen i løpet av en nær fremtid, er implikasjonene av det enorme. Hvis du noen gang har fått dårlig informasjon etter et online søk, kan dette nye scoringssystemet endre alt dette etter rangering av nettsteder basert på resultater i Googles Knowledge Vault (faktabutikker hentet fra indeksert innhold) og hvor godt de har det matche opp.

Til slutt, å prøve å forutsi hvordan søkemotorteknologi utenom det neste året eller to ser ut er en suveren øvelse i nytteløshet. Når det er sagt, bør det fortsette å komme oss et skritt nærmere en tidsalder der vi møttes svaret på ethvert spørsmål på en nærmest øyeblikkelig måte.

Er det en bedre søkemotor enn Google? Hva gjør det bedre? Hvilke søkerelaterte teknologier eller endringer er du mest spent på å se i løpet av den nærmeste fremtiden? Lyd av i kommentarene nedenfor. Jeg vil gjerne høre hva du tar!

Bildekreditt: Søkemotor via Shutterstock, Firefox Mobile av Johan Larsson via Flickr, Optimalisering av nettstedkode via Shutterstock

Bryan er en USA-født utvist som for tiden bor på den solfylte Baja-halvøya i Mexico. Han liker vitenskap, tech, dingser og å sitere Will Ferrel-filmer.