Annonse

Datarihistorien er full av Flops.

De Apple III hadde en stygg vane å tilberede seg selv i sitt deformerte skall. De Atari Jaguar, en ‘nyskapende’ spillkonsoll som hadde noen falske påstander om ytelsen, kunne bare ikke ta tak i markedet. Intels flaggskip Pentium-brikke designet for høyytelsesregnskapsmessige applikasjoner hadde problemer med desimaltall.

Men den andre typen flopp som råder i databehandlingsverdenen er FLOPS måling, lenge hyllet som en rimelig sammenligning mellom forskjellige maskiner, arkitekturer og systemer.

FLOPS er et mål på flytende punktoperasjoner per sekund. Enkelt sagt, det er hastighetsmåleren for et datasystem. Og det har det vært vokser eksponentielt i flere tiår.

Så hva hvis jeg fortalte deg at om noen år, vil du ha et system som sitter på skrivebordet ditt, eller på TV-en eller på telefonen din, som vil tørke gulvet i dagens superdatamaskiner? Utrolig? Jeg er en gal? Ta en titt på historien før du dømmer.

Superdatamaskin til supermarked

En nylig Intel i7

Haswell Så hva er forskjellen mellom Intels Haswell- og Ivy Bridge-prosessorer?Ser du etter en ny datamaskin? De som handler etter en ny Intel-drevet bærbar eller stasjonær datamaskin, trenger å vite forskjellene mellom den siste og den siste generasjonen av Intel-prosessorer. Les mer prosessor kan utføre omtrent 177 milliarder FLOPS (GFLOPS), som er raskere enn den raskeste superdatamaskinen i USA i 1994, the Sandia National Labs XP / s140 med 3680 datakjerner som jobber sammen.En PlayStation 4 kan operere på rundt 1,8 billioner FLOPS takket være den avanserte Cellemikroarkitektur, og ville ha trumfet $ 55 millioner ASCI Red superdatamaskin som toppet den verdensomspennende superdatameligaen i 1998, nesten 15 år før PS4 ble utgitt.

IBMs Watson AI-system IBM avslører revolusjonerende "hjerne på en chip"Forkynnet forrige uke via en artikkel i Science, "TrueNorth" er det som er kjent som en "nevromorf chip" - en datamaskinbrikke designet for å imitere biologiske nevroner, for bruk i intelligente datasystemer som Watson. Les mer har en (nåværende) toppdrift 80 TFLOPS, og det er ikke i nærheten av å la den inn på Topp 500-listen over dagens superdatamaskiner, med Kinesiske Tianhe-2 på vei til topp 500 de siste tre påfølgende anledninger, med en topp ytelse på 54,902 TFLOPS, eller nesten 55 Peta-FLOPS.

Det store spørsmålet er, hvor er neste stasjonær superdatamaskin Den siste datateknologien du må se for å troTa en titt på noen av de nyeste datateknologiene som er ment å transformere elektronikken og PC-verdenen de neste årene. Les mer kommer til å komme fra? Og enda viktigere, når får vi det til?

Nok en murstein i maktveggen

I nyere historie har drivkreftene mellom disse imponerende gevinstene i hastighet vært innen materialvitenskap og arkitekturdesign; mindre produksjonsprosesser av nanometer skala gjør at flisene kan være tynnere, raskere og dumpe mindre energi ut i form av varme, noe som gjør dem billigere å kjøre.

Med utviklingen av flerkjernearkitekturer på slutten av 2000-tallet, blir mange "prosessorer" nå presset på en enkelt brikke. Denne teknologien, kombinert med den økende modenheten til distribuerte beregningssystemer, hvor mange ‘Datamaskiner’ kan fungere som en enkelt maskin, betyr at Top 500 alltid har vokst, omtrent å beholde takt med Mores berømte lov.

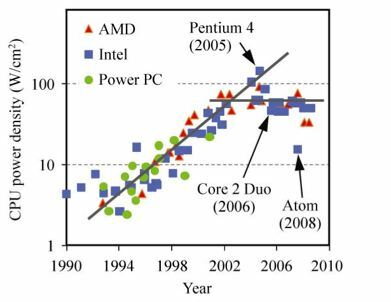

Imidlertid fysikklover begynner å komme i veien for all denne veksten, til og med Intel er bekymret for det, og mange over hele verden jakter på neste ting.

... om omtrent ti år vil vi se sammenbruddet av Moore's Law. Faktisk ser vi allerede en avtakelse av Moore's Law. Datakraft kan ganske enkelt ikke opprettholde den raske eksponentielle økningen ved bruk av standard silisiumteknologi. - Dr. Michio Kaku – 2012

Det grunnleggende problemet med nåværende prosessdesign er at transistorene er enten på (1) eller av (0). Hver gang a transistor gate "Vipper", det må utvise en viss mengde energi i materialet som porten er laget av for å få den "vippen" til å bli. Når disse portene blir mindre og mindre, blir forholdet mellom energien til å bruke transistoren og energi til å "vende" transistoren blir større og større, og skaper større oppvarming og pålitelighet problemer. Nåværende systemer nærmer seg - og i noen tilfeller over - den rå varmetettheten til atomreaktorer, og materialer begynner å svikte designerne. Dette kalles klassisk ‘Power Wall’.

Nylig har noen begynt å tenke annerledes om hvordan du utfører nyttige beregninger. Spesielt to selskaper har fanget vår oppmerksomhet når det gjelder avanserte former for kvante- og optisk databehandling. Canadian D-Wave-systemer og Storbritannia basert Optalysys, som begge har ekstremt forskjellige tilnærminger til veldig forskjellige problemstillinger.

På tide å endre musikken

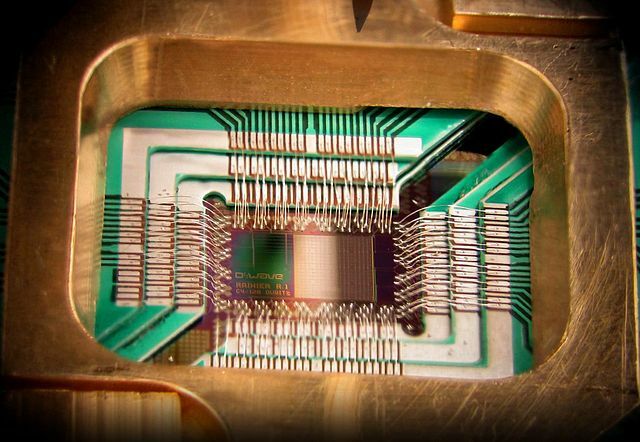

D-Wave fikk mye press i det siste, med deres superkjølte illevarslende, svarte boks med en ekstremt cyberpunk interiørspyd, som inneholder en gåtefull nakenbrikke med vanskelig å forestille seg krefter.

I hovedsak tar D2-systemet en helt annen tilnærming til problemløsing ved effektivt å kaste ut årsak-og-virkning-regelboka. Så hva slags problemer er denne støttede skjemoten Google / NASA / Lockheed Martin som sikter mot?

The Rambling Man

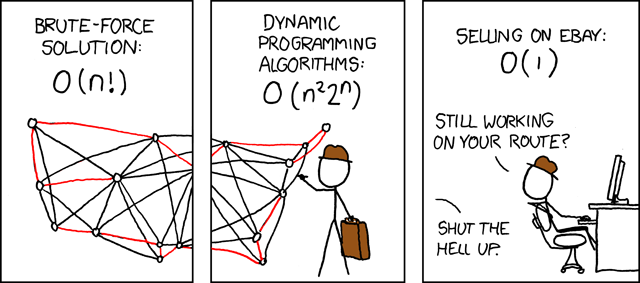

Historisk sett hvis du vil løse et NP-hardt eller mellomliggende problem, der det er et ekstremt høyt antall mulige løsninger som har et bredt spekter av potensial, ved å bruke ‘verdier’ fungerer den klassiske tilnærmingen ganske enkelt ikke. Ta for eksempel Problemet med Travellersalg; gitt N-byer, finn den korteste veien å besøke alle byer en gang. Det er viktig å merke seg at TSP er en viktig faktor på mange felt som mikrobrikkeproduksjon, logistikk og til og med DNA-sekvensering,

Men alle disse problemene koker ned til en tilsynelatende enkel prosess; Velg et punkt å starte fra, generer en rute rundt N 'ting', måle avstanden og hvis det er en eksisterende rute som er kortere enn den, kast den forsøkte ruten og gå videre til neste til det ikke er flere ruter til kryss av.

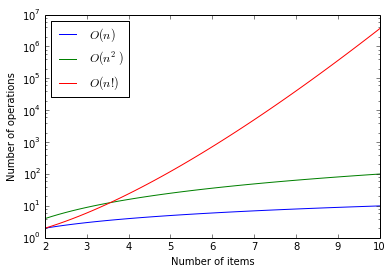

Dette høres enkelt ut, og for små verdier er det det; for 3 byer er det 3 * 2 * 1 = 6 ruter å sjekke, for 7 byer er det 7 * 6 * 5 * 4 * 3 * 2 * 1 = 5040, noe som ikke er så ille for en datamaskin å håndtere. Dette er en Fakultet sekvens, og kan uttrykkes som "N!", så 5040 er 7 !.

Når du bare drar litt lenger, til 10 byer å besøke, må du imidlertid teste over 3 millioner ruter. Når du kommer til 100, er antall ruter du trenger å sjekke 9 etterfulgt av 157 sifre. Den eneste måten å se på denne typen funksjoner er å bruke en logaritmisk graf, der y-aksen starter ved 1 (10 ^ 0), 10 (10 ^ 1), 100 (10 ^ 2), 1000 (10 ^ 3) ) og så videre.

Tallene blir bare for store til å kunne behandle på en hvilken som helst maskin som eksisterer i dag eller kan eksistere ved hjelp av klassiske databehandlingsarkitekturer. Men hva D-Wave gjør er veldig annerledes.

Vesuv kommer frem

Vesuv-brikken i D2 bruker rundt 500 ‘qubits‘Eller Quantum Bits’ for å utføre disse beregningene ved å bruke en metode som heter Kvantealgling. I stedet for å måle hver rute om gangen, settes Vesuvius-kubittene inn i en superposisjonstilstand (verken av eller på, drift sammen som et slags potensielt felt) og en serie stadig mer komplekse algebraiske beskrivelser av løsningen (dvs. en serie av Hamilton beskrivelser av løsningen, ikke en løsning i seg selv) brukes på superposisjonsfeltet.

I virkeligheten tester systemet egnetheten til enhver potensiell løsning samtidig, som en ball som "bestemmer" hvilken vei å gå ned en bakke. Når superposisjonen er avslappet til en grunntilstand, skal grunntilstanden til qubits beskrive den optimale løsningen.

Mange har stilt spørsmål ved hvor stor fordel D-Wave-systemet gir i forhold til en konvensjonell datamaskin. I en fersk test av plattformen mot et typisk Travelling Saleman Problem, som tok 30 minutter for en klassisk datamaskin, tok bare et halvt sekund på Vesuv.

For å være tydelig, vil dette aldri bli et system du spiller Doom på. Noen kommentatorer prøver å gjøre det sammenligne dette høyspesialiserte systemet med en generell prosessor. Du vil være bedre å sammenligne en Ohio-klasse ubåt med F35 Lyn; enhver beregning du velger for den ene er så upassende for den andre at den er ubrukelig.

D-Wave klokker seg inn på flere størrelsesordener raskere for sine spesifikke problemer sammenlignet med en standard prosessor, og FLOPS estimater spenner fra en relativt imponerende 420 GFLOPS til en tankevekkende 1,5 Peta-FLOPS (Setter den på topp 10 Supercomputer-listen i 2013 på tidspunktet for den siste offentlige prototypen). Hvis noe, fremhever denne forskjellen begynnelsen på slutten av FLOPS som en universell måling når den brukes på spesifikke problemområder.

Dette området for databehandling er rettet mot et veldig spesifikt (og veldig interessant) sett med problemer. Bekymringsverdig er et av problemene innenfor denne sfæren kryptografi Slik krypterer du Gmail, Outlook og annen nettpostE-postkontoer har nøklene til din personlige informasjon. Slik krypterer du Gmail, Outlook.com og andre e-postkontoer. Les mer - spesielt Public Key Cryptography.

Heldigvis virker implementeringen av D-Wave fokusert på optimaliseringsalgoritmer, og D-Wave tok noen designbeslutninger (for eksempel den hierarkiske peering-strukturen på brikken) som indikerer at du ikke kunne bruke Vesuvets å løse Shor's algoritme, som potensielt ville låst opp Internett så dårlig det ville gjøre Robert Redford stolt.

Laser Matematikk

Det andre selskapet på listen vår er Optalysys. Dette britiske baserte selskapet tar databehandling og vender det på hodet ved å bruke analog superposisjon av lys for å utføre visse beregningsklasser ved å bruke selve lysets natur. Videoen nedenfor viser noe av bakgrunnen og det grunnleggende i Optalysys-systemet, presentert av Prof. Heinz Wolff.

Det er litt håndbølget, men i hovedsak er det en boks som forhåpentligvis en dag vil sitte på skrivebordet ditt og tilby beregningsstøtte for simuleringer, CAD / CAM og medisinsk bildebehandling (og kanskje, bare kanskje, datamaskin spill). I likhet med Vesuv er det ingen måte som Optalysys-løsningen skal utføre mainstream dataoppgaver, men det er ikke det den er designet for.

En nyttig måte å tenke på denne typen optisk prosessering er å tenke på den som en fysisk grafikkbehandlingsenhet (GPU). Moderne GPU Bli kjent med grafikkakseleratoren din i ulidelig detalj med GPU-Z [Windows]GPU, eller grafikkbehandlingsenhet, er den delen av datamaskinen som har ansvaret for håndtering av grafikk. Med andre ord, hvis spill er hakkete på datamaskinen din eller den ikke takler innstillinger av veldig høy kvalitet, ... Les mer Bruker mange mange streamingprosessorer parallelt, og utfører den samme beregningen på forskjellige data som kommer inn fra forskjellige minneområder. Denne arkitekturen kom som et naturlig resultat av måten datagrafikken er generert på, men denne massivt parallelle arkitekturen har blitt brukt til alt fra høyfrekvent handel, til Kunstige nevrale nettverk.

Optalsys tar lignende prinsipper og oversetter dem til et fysisk medium; datapartisjonering blir strålesplitting, lineær algebra blir kvanteinterferens, MapReduce stilfunksjoner blir optiske filtreringssystemer. Og alle disse funksjonene fungerer i konstant, effektivt øyeblikkelig tid.

Den første prototypenheten bruker et 20Hz 500 × 500 elementnett for å utføre Fast Fourier Transformations (i utgangspunktet “hvilke frekvenser vises i denne inngangsstrømmen?”) og har levert et underveldende ekvivalent av 40 GFLOPS. Utviklere er målrettet mot et 340 GFLOPS-system av neste år, som vurderer det estimerte strømforbruket, ville være en imponerende poengsum.

Så hvor er min svarte boks?

De databehandlingshistorie En kort historie om datamaskiner som forandret verdenDu kan bruke år på å dykke ned i datamaskinens historie. Det er mange oppfinnelser, mange bøker om dem - og det er før du begynner å komme inn i fingerspissen som uunngåelig skjer når ... Les mer viser oss at det som i utgangspunktet er reserven til forskningslaboratorier og offentlige etater raskt tar vei inn i forbrukerens maskinvare. Dessverre har databehandlingshistorien ikke hatt noen ting å gjøre med begrensningene i fysikkens lover.

Personlig tror jeg ikke D-Wave og Optalysys kommer til å være de eksakte teknologiene vi har på pultene våre om 5-10 år. Tenk på at den første gjenkjennelige "Smartklokke" ble avduket i 2000 og mislyktes elendig; men essensen av teknologien fortsetter i dag. På samme måte vil sannsynligvis disse utforskningene i Quantum og Optical computing-akseleratorer ende som fotnoter i ‘den neste store tingen’.

Materialvitenskap kantles nærmere biologiske datamaskiner, ved hjelp av DNA-lignende strukturer for å utføre matematikk. Nanoteknologi og ‘Programmerbar Matter’ nærmer seg poenget i stedet for å behandle ‘data’, materialet i seg selv vil både inneholde, representere og behandle informasjon.

Alt i alt er det en modig ny verden for en beregningsforsker. Hvor tror du dette går? La oss chatte om det i kommentarene!

Fotokreditt:KL Intel Pentium A80501 av Konstantin Lanzet, Asci rød - tflop4m av USAs regjering - Sandia National Laboratories, DWave D2 av The Vancouver Sun, DWave 128chip av D-Wave Systems, Inc., Reisende selgerproblem av Randall Munroe (XKCD)

Om dagen er jeg forsker ved University of Liverpool som undersøker tillit og omdømme innen marin kommunikasjon for autonome systemer. Om natten er jeg grunnlegger av Farset Labs, Nord-Irlands første Hackerspace, samt konsulterer lokale myndigheter, næringsliv, akademia og frivillig sektor om STEM Outreach, Business Innovation Strategy and Communications & Datasikkerhet.